机器学习与 AI

-

WWDC24 -

20:03

20:03

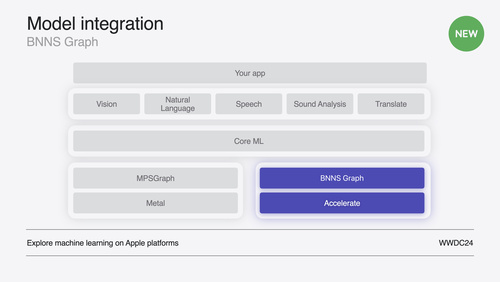

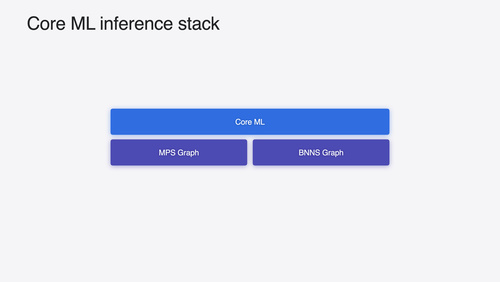

在 CPU 上助力实现实时 ML 推理

探索如何使用 BNNSGraph 加快机器学习模型在 CPU 上的执行。我们将展示如何使用 BNNSGraph 在 CPU 上编译和执行机器学习模型,并介绍它通过哪些方式为音频或信号处理模型提供实时保证,例如避免运行时内存分配,以及采用单线程运行。

-

17:56

17:56

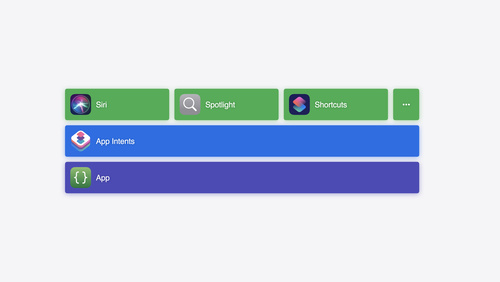

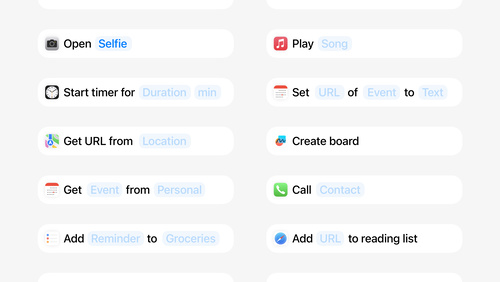

App Intents 的新功能

了解 App Intents 有哪些改进和提升,并探索这个框架如何帮助你将 App 的功能公开给 Siri 和其他新功能。我们将介绍如何使用 Transferable API、File Representations、Item Providers 以及 Spotlight Indexing 让你的实体在平台中更有意义,从而通过 Siri 和“快捷指令”App 实现强大的功能。使用 URL Representable Entities 和灵活的场景 API 来增强你的意图,帮助用户深入探索你的 App。探索相关的新技术,以通过用于错误处理、延迟属性和关联枚举的新 API 为你的实体和意图建模。

-

11:32

11:32

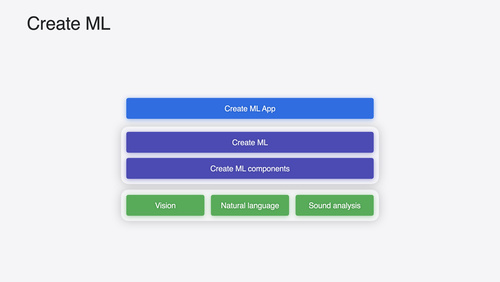

Create ML 的新功能

探索 Create ML 的更新,包括交互式数据源预览,以及用于为 visionOS App 构建对象追踪模型的新增模板。我们还将介绍重要的框架改进,包括新的时间序列预测和分类 API。

-

12:24

12:24

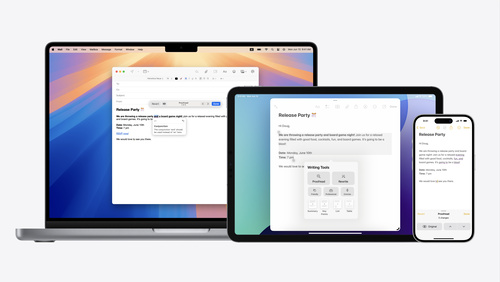

开始使用 Writing Tools

了解 Writing Tools 如何帮助用户校对、改写和转换在 App 中输入的文本。详细了解 Writing Tools 如何与你的 App 交互,以便用户可以在任一文本视图中改进已编写的内容。了解文本的检索和处理方式,以及如何为自定文本视图中的 Writing Tools 使用提供支持。

-

26:02

26:02

利用 App Intents 为用户奉上 App 的核心功能

了解 App Intents 框架的要素 (例如,意图、实体和查询),以及如何利用这些要素恰到好处地显示 App 最重要的功能以满足用户所需。了解如何将你的 App 与众多基于 App Intents 的系统功能深度整合起来,这些功能包括 Siri、控件和小组件、Apple Pencil、快捷指令、操作按钮等等。获取相关的技巧,学习如何高效实现 App Intents 整合,以打造全方位的卓越体验,同时仍能共享代码和核心功能。

-

18:21

18:21

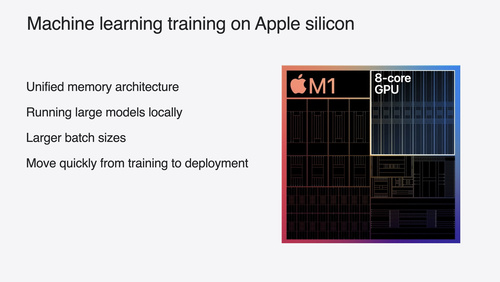

基于 Apple GPU 训练机器学习和 AI 模型

了解如何借助适用于 PyTorch、JAX 和 TensorFlow 的 Metal 工具,在 Apple 芯片上训练模型。充分利用新的注意力操作和量化支持,提升设备端 Transformer 模型性能。

-

16:49

16:49

探索 Vision 框架中的 Swift 增强功能

Vision Framework API 经过重新设计,旨在利用并发等现代 Swift 功能,更轻松快速地将各种 Vision 算法整合到你的 App 中。我们将一起了解更新后的 API,并分享示例代码以及推荐做法,帮你在精简编程工作的同时仍能充分发挥该框架的优势。我们还将展示两项新功能:图像美学和整体身体姿势。

-

17:33

17:33

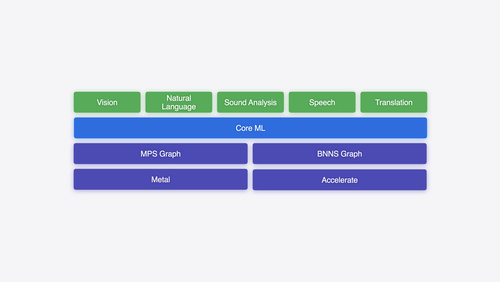

在 Apple 平台上探索机器学习

开始简要了解 Apple 平台上的机器学习框架。无论你是准备实现首个 ML 模型,还是 ML 方面的专家,我们都将提供相应的指导,帮你根据 App 的具体需求选择合适的框架。

-

22:49

22:49

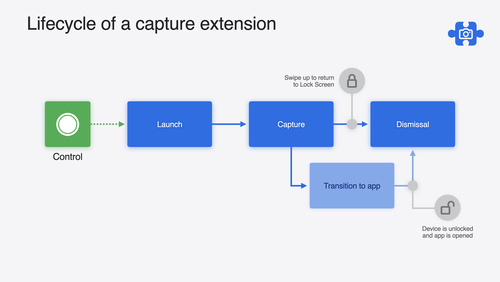

打造出色的锁定屏幕相机拍摄体验

了解 LockedCameraCapture API 如何帮你将拍摄应用程序最有用的信息直接整合到锁定屏幕。研究这个 API 的特性和功能,了解如何开始构建拍摄扩展,并探索此扩展在设备锁定时的运行情况。

-

9:19

9:19

利用 App Intents 设计提升系统体验

App Intents 为控件、“聚焦”、Siri 等方面的系统体验提供了强大支持。了解如何识别最适合 App Intents 的功能,以及如何利用参数让此类意图更灵活。了解如何使用 App Intents 让用户在你的 App 之外完成相关操作,并通过几个示例了解应在何时导航到自己的 App 来显示情境信息。

-

16:31

16:31

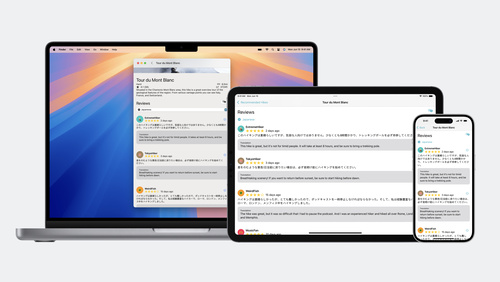

了解 Translation API

探索如何使用新的 Translation 框架,将 App 中的文本翻译成不同的语言。 我们会介绍如何在系统 UI 中快速显示翻译,以及如何为自己 App 的 UI 进行更大规模的批量文本翻译。

-

16:06

16:06

DockKit 的新功能

探索 DockKit 中的智能跟踪如何助你实现更顺畅的主体转换。我们将介绍什么是智能跟踪、它如何使用 ML 模型来选择并跟踪主体,以及如何在你的 App 中加以运用。

-

34:29

34:29

利用 HDR 为 App 打造动态图像体验

探索如何在 App 中完成 HDR 图像的读写操作,以及处理 HDR 内容。探究新增的受支持 HDR 图像格式,以及多种显示 HDR 图像的先进方法。了解 HDR 内容可以如何与你的用户界面实现共存,以及为 App 添加 HDR 图像支持时有哪些注意事项。

-

30:09

30:09

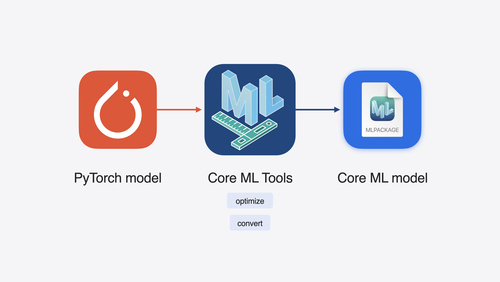

将机器学习和 AI 模型移植到 Apple 芯片

了解如何优化机器学习和 AI 模型,以充分利用 Apple 芯片的澎湃动力。查看模型转换工作流程,为设备端模型部署做好准备。了解 Apple 芯片支持的模型压缩方法,以及可在模型部署流程中的哪些阶段应用这些方法。我们还将探索如何在占用空间、延迟、功耗和准确度之间取得平衡。

-

10:55

10:55

使用 Core Spotlight 支持语义搜索

了解如何使用 Core Spotlight 在 App 中提供语义搜索结果。探索如何让自己 App 的内容出现在用户的设备端私有索引中,以便用户可以使用自然语言来搜索项目。我们还将介绍如何安排索引编制活动来优化 App 的性能。 为了充分利用好本次讲座,我们建议你先查阅 Apple Developer 网站上的 Core Spotlight 文档。

-

21:49

21:49

带你的 App 登陆 Siri

了解如何利用 App Intents 将你的 App 功能公开给 Siri。了解有哪些现成的意图可供使用,以及如何创建自定意图以将你 App 中的操作整合到系统中。我们还将介绍应提供哪些元数据、如何确保实体支持“聚焦”搜索、如何标注屏幕引用,等等。

-

23:48

23:48

确保拍摄的画面在颜色上保持一致

了解 Constant Color API,并探索该 API 如何帮助用户使用你的 App 来确定精准的颜色。你将学习如何采用该 API,了解它在科研和营销方面的潜力,并探索充分利用这种技术的推荐做法。

-

17:01

17:01

探索适用于 visionOS 的对象追踪

探索如何使用对象追踪功能,在 visionOS App 中将现实世界的对象转化为虚拟锚点。了解如何使用对象追踪功能从头到尾打造空间体验。探索如何利用 Create ML 中的机器学习功能创建参考对象,并将相对于目标对象的内容附加到 Reality Composer Pro、RealityKit 或 ARKit API 中。

-

18:15

18:15

利用 Core ML 在设备端部署机器学习和 AI 模型

了解在通过 Core ML 转换及运行机器学习和 AI 模型时,可以借助哪些新方式来优化速度表现和内存利用率。我们会介绍有关模型表示、性能洞察信息、执行以及模型拼接的新选项,你可以搭配使用这些选项,打造引人入胜又注重隐私保护的设备端体验。

-

21:18

21:18

为你介绍适用于 visionOS 的企业 API

探索如何利用适用于 visionOS 的全新企业 API 打造空间体验,帮助使用 Apple Vision Pro 的员工和顾客提升效率。

-

25:06

25:06

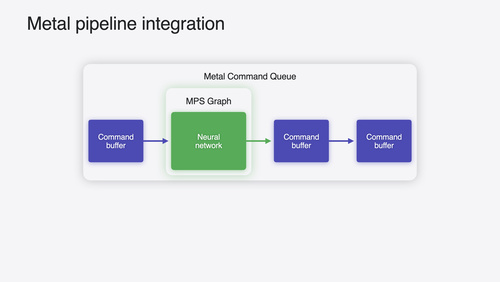

利用 Metal 加快机器学习

了解如何利用 Metal Performance Shaders Graph 中的新功能来加快你的机器学习 Transformer 模型。我们还将介绍如何提升自己模型的计算带宽和质量,并利用全新的 MPSGraph 视图直观呈现模型。

-

-

WWDC23 -

13:47

13:47

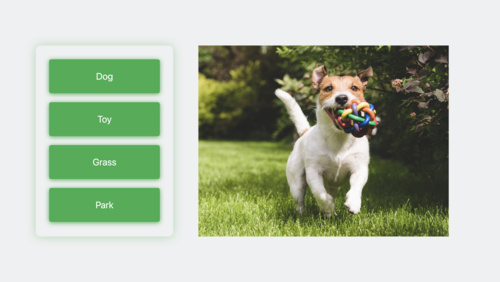

在 Vision 中检测动物体态

除了检测图片中的猫和狗,我们还将向你展示如何使用 Vision 实时检测动物的单个关节和它们的体态,以及如何实现一些令人激动的功能,例如使用相机 App 进行动物跟踪,为动物图片应用创意装饰等。我们还将深入探讨 Vision 框架中的其他重要更新,并与你分享最佳实践。想要了解更多有关 Vision 框架新技术的信息,欢迎观看“探索 Vision 中 3D 人体姿势及人像分割”以及“在 App 中提取图片主体”。此外,想要了解更多有关构建实时相机追踪的体验,欢迎观看“使用 DockKit 集成电动 iPhone 支架”。

-

16:50

16:50

探索 Create ML 中的机器学习更新

了解 Create ML 如何帮助你利用机器学习模型完成更多任务,以及使用多语言 BERT 嵌入进行图像识别和完成基于文本的任务的最新功能,探索如何轻松使用多标签分类训练出能够识别图像内容的模型。此外,本期视频还介绍了有关交互式模型评估和用于自定义训练数据增强的最新 API 的相关信息。欲了解机器学习的相关更新,请观看 WWDC23 视频“探索 Natural Language 多语言模型”和“通过异步预测改进 Core ML 集成”。

-

19:56

19:56

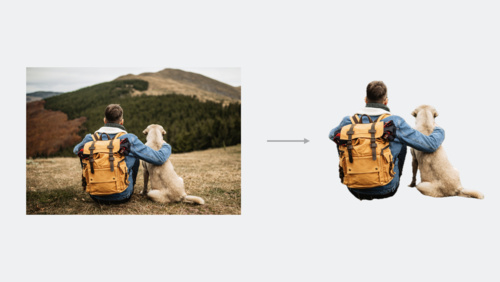

VisionKit 的新功能

了解 VisionKit 如何帮助用户快速在你的 App 中提取图像主题,以及如何使用可视化查看获取图像内容更多有关信息。我们还将为你介绍 VisionKit 中的最新更新,包括实时文本交互、数据扫描以及针对 macOS App 的扩展支持。想要进一步了解有关 VisionKit 的信息,请查看 WWDC23 中的“在你的 App 中提取图像主题”。

-

18:38

18:38

在你的 App 中提取图像主题

了解如何在你的 App 中轻松地从背景提取图像主题。学习如何使用 VisionKit 提取主题或提取指定点所选中的主题。我们还将分享如何使用 Vision 来提取主题,并将其与 Core Image 等底层框架结合使用,以创建有趣的图像效果和更复杂的合成流程。有关 VisionKit 最新更新的更多信息,请查看 “VisionKit 新功能” 。有关图像中人像分割的更多信息,请观看 WWDC23 视频“探索 Vision 中的 3D 人体姿态和人像分割 ”。

-

14:25

14:25

探索自然语言多语言模型

了解如何使用多语言、基于 Transformer 的嵌入创建用于文本分类和词语标记的自定义自然语言模型。我们将向你展示如何使用较少的数据进行训练,并在 3 个脚本中实现对多达 27 种语言的支持。了解如何使用此类嵌入微调利用 PyTorch 和 TensorFlow 训练的复杂模型。想要了解更多有关自然语言的内容,欢迎观看 WWDC20 中“利用自然语言让 App 更加智能”。

-

14:38

14:38

在 Vision 中探索 3D 人体位姿和人像分隔

了解如何使用 Vision 构建以人像为中心的的功能。了解如何检测人体位姿并测量 3D 空间中的各个关节位置。我们还将向你展示如何利用人像分隔 API 来区分和分隔图片上的人像,最多可处理四个人。 要了解有关 Vision 最新功能的更多信息,请观看 WWDC23 课程“在 Vision 中检测动物位姿”。

-

17:35

17:35

使用 DockKit 与电动 iPhone 支架集成

了解如何在与 DockKit 兼容的电动支架集成后在相机 App 中创造令人难以置信的照片和视频拍摄体验。我们将展示你的 App 如何在 360° 视野中自定义取景、直接控制电机以及采用你自己的推理模型来跟踪其他对象,做到自动跟踪实时视频中的主体,同时对支架进行直接控制。最后,我们将演示如何通过动态设备动画来表达情感。要了解更多图像跟踪技术,请查看 WWDC23 的“Vision 框架下的动物位姿检测”和 WWDC21 的“使用 Create ML 进行手势动作分类”两个视频。

-

25:18

25:18

使用 Core ML Tools 进行机器学习模型压缩

了解如何借助 Core ML Tools 减少 App 中机器学习模型的占用空间。了解如何使用调色板、剪枝和量化等技术实现模型大小显著减小,同时仍保持较高的精度。探索训练时压缩与对经过训练的模型进行压缩之间的差异,以及如何利用 Apple 神经网络引擎让经过压缩的模型在你的 App 中运行更快。想要了解有关优化 Core ML 的更多信息,欢迎观看 WWDC23 中的“通过异步预测改进 Core ML 集成”讲座。

-

21:15

21:15

为 Metal App 优化机器学习

了解 Metal 中加速的 ML 训练的最新改进。了解 PyTorch 和 TensorFlow 的更新,以及针对 JAX 的 Metal 加速。我们将向你展示在同时使用 GPU 和 Apple 神经网络引擎时,MPS Graph 如何支持更快的 ML 推理;同时,我们还将与你分享如何将同一个 API 快速集成到 Core ML 和 ONNX 模型中。欲了解更多有关使用 Metal 进行机器学习的内容,欢迎观看 WWDC22 中的“使用 Metal 加速机器学习”。

-

23:21

23:21

使用异步预测改进 Core ML 集成

了解如何使用最新的 Core ML 执行引擎改进来加速 App 中的机器学习功能,以及积极的资源缓存是如何帮助推理和更快的模型加载。我们将会向你展示最新的异步预测选项,并探讨平衡性能和总体内存使用率的多种考量,从而帮助你打造反应敏捷的 App。深入了解 API 以帮助你理解并最大程度地提高模型中的硬件利用率。想要进一步了解有关优化 Core ML 模型使用的内容,请查看 WWDC23 中的”使用 Core ML Tools 进行机器学习模型压缩”。

-

7:52

7:52

自定义设备上的语音识别

了解如何通过使用额外词汇自定义底层模型来改进 App 设备上的语音识别。我们将分享语音识别在设备上的工作机制,并向你展示如何增强特定单词和短语以获得更可预测的转录。了解如何为单词提供特定发音并使用模板支持快速生成一整套自定义短语 - 所有这些都在运行时进行。有关语音框架的更多信息,请查看 WWDC19 的“语音识别进展”讲座。

-

-

WWDC22 -

25:31

25:31

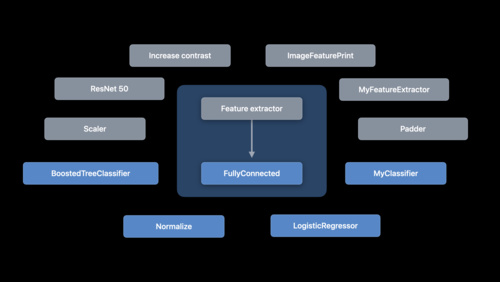

了解 Create ML 组件

Create ML 使为图像分类、物体检测、声音分类、手势分类、动作分类、表格数据回归等构建自定义机器学习模型变得更加简单。借助 Create ML 组件框架,您可以进一步自定义底层任务并优化您的模型。我们将探索组成此类任务的特征提取器、转换器和估算器,并向您介绍如何将其与其他组件和预处理步骤组合起来,以便为图像回归等概念构建自定义任务。 要了解有关创建复杂可自定任务的更多信息,我们建议您观看 WWDC22 的“利用 Create ML 组件构建高级模型”。

-

12:11

12:11

利用 VisionKit 捕捉机器可读的代码和文本

了解 VisionKit 中的数据扫描器:此框架整合了 AVCapture 和 Vision,通过简单的 Swift API 实现对机器可读代码和文本的实时捕捉。我们将介绍如何指定条码符号系统和语言选择,从而控制 App 可以捕捉的内容类型。我们还将探索如何启用 App 中的指引,自定义物体高亮显示或兴趣区域,以及在您的 App 检测到某个物体后如何进行交互。要进一步了解如何通过静态图片或暂停视频帧与“实时文本”进行交互,请观看 WWDC22 的“在您的 App 中添加‘实时文本'交互”。

-

16:46

16:46

Create ML 的新功能

体验最新的 Create ML 更新。我们将分享 Create ML 评估工具的改进,这些工具可以帮助您了解您的自定义模型将如何处理现实世界的数据。学习如何检查模型在处理测试数据的每种图像类型时的性能,并确定个别图像中存在的问题,以便帮助您排除错误分类、标记不良和其他错误。我们还将向您介绍如何借助连续互通相机在实时预览中用 iPhone 和 iPad 测试您的模型,分享如何利用 Create ML 组件框架中新增的重复计数功能进一步优化动作分类。要详细了解 Create ML 可以为您的 App 增加哪些优势,请观看 WWDC21 的“使用 Create ML 将手势和动作分类”和“使用...

-

13:25

13:25

利用 Create ML 组件构建高级模型

利用 Create ML 组件将您的自定义机器学习模型提高到新的水平。我们将介绍如何处理视频或音频等时态数据,并构建可计算重复人为操作次数或提供高级声音分类的模型。我们还将分享有关使用增量拟合,以新数据加快模型训练的最佳实践。要简单了解自定义机器学习模型,请观看 WWDC22 的“了解 Create ML 组件”。

-

23:30

23:30

优化您的 Core ML 使用情况

了解 Core ML 如何与 CPU、GPU 和神经网络引擎协同运行,在设备上为您的 App 提供保护隐私的机器学习体验。我们将探索最新的工具,以便理解并最大限度提高您的模型性能。我们还会介绍如何生成报告来轻松理解您的模型性能特性,帮助您借助 Core ML Instrument 洞察模型,并带您了解 API 增强功能,进一步优化 App 中的 Core ML 集成。为能更好地理解此讲座,请确保观看 WWDC21 的“调整您的 Core ML 模型”。

-

19:48

19:48

Vision 的新功能

了解 Vision API 的最新更新,它可以帮助您的 App 识别文本、检测面部和面部特征点,以及执行光流处理。我们将向您介绍基于视频的 App 的光流处理功能,如何通过修改驱动这些 API 的机器学习模型来更新您的 App,并探索如何借助 Xcode 中的“快速查看预览支持”直观呈现您的 Vision 任务。为能更好地理解此讲座,我们建议您先观看 WWDC21 的“使用 Vision 检测人物、面孔和姿势”讲座。

-

29:51

29:51

利用 Metal 为机器学习加速

了解如何在 macOS 上使用 Metal 加快您的 PyTorch 模型训练。我们将介绍 TensorFlow 训练支持的更新,探索 MPS Graph 的最新功能和操作,并分享最佳实践以帮助您提升性能,满足您对机器学习的需求。要进一步了解如何搭配使用 Metal 和机器学习,请观看 WWDC21 的“使用 Metal Performance Shaders Graph 加快机器学习速度”。

-

17:19

17:19

探索机器学习开发体验

了解如何将基于机器学习 (ML) 的一流体验融入到您的 App。我们将介绍模型发现、转换和训练,并提供有关 ML 的技巧和最佳实践。我们还将分享在开始您的 ML 旅程时应考虑的注意事项,演示评估模型性能的技术,以及探索如何对模型进行微调,以便在设备上获得出色的实时性能。要进一步了解这个讲座所讨论的技术,请观看 WWDC22 的“优化您的 Core ML 使用情况”和“利用 Metal 为机器学习加速”。

-

-

Tech Talks -

15:48

15:48

在 Create ML 中改进对象检测模型

在 Create ML 中训练自定义 Core ML 模型用于对象检测时,你可以把图像理解引入自己的 app。了解迁移学习如何让你能够以更少的训练数据构建更小的模型。我们还会详细介绍 Create ML 中的一些高级参数,它们能帮助你控制输入图像的训练迭代次数、批量大小和网格大小,让你更好地控制模型的精确度。 关于对象检测的介绍,请观看 WWDC 2019 年度的视频《在 Create ML 中训练对象检测》。

-

23:48

23:48

使用 TabularData 在 Swift 中探索和处理数据

探索如何使用 TabularData 框架在 Swift 中加载、探索和处理非结构化数据。无论您是需要为机器学习任务预处理数据,还是需要在 app 中实时生成数据摘要,这个框架都会对您有所帮助。了解这个框架如何帮助您处理大型数据集、将多个数据表格联接在一起,以及通过编程方式筛选数据。此外,我们还将向您展示如何在您的 app 中使用 DataFrame 来推动实现所有以数据为中心的功能。

-

25:18

25:18

将 PyTorch 模型转换为 Core ML

将 PyTorch 模型转换为 Core ML,探索在 app 中如何利用设备端的机器学习。 PyTorch 机器学习框架可以帮助你创建和训练复杂的神经网络。构建这些模型后,你可以将它们转换为 Core ML 并完全在设备端运行,从而充分利用中央处理器、图形处理器和神经网络引擎。 了解 coremltools 软件包如何直接转换 TorchScript 模型,同时深入了解如何处理自定义操作及可能出现的转换错误。 要了解有关 Core ML 转换器的更多信息,建议观看 WWDC20 视频《使用 Core ML 转换器为设备获取模型》。

-

-

WWDC21 -

19:16

19:16

探索 SoundAnalysis 中内置的声音分类

探索如何在您的 app 中使用 Sound Analysis 框架来检测和分类来自任何音频源的离散声音,包括来自麦克风的现场声音或来自视频音频文件的声音,并在声音发出的瞬间精确识别。了解内置声音分类器如何让您轻松识别 300 多种不同类型的声音,而无需自定义的受训模型。包括人声、乐器、动物和各种物品的各种声音。对于自定义模型,请参阅如何利用 Audio Feature Print 功能提取器创建具有可变声音窗口控制的较小模型,以更好地满足您 app 的用途。有关声音分类和 Sound Analysis 框架的更多信息,请观看 WWDC19 中的“在 Create ML 中训练声音分类模型”。

-

17:58

17:58

使用 Vision 检测人物、面孔和姿势

了解 Vision 框架的最新更新,帮助您的 app 检测人物、面孔和姿势。了解 Person Segmentation API,它可以帮助您的 app 将图像中的人与周围环境区分开来,并探索用于跟踪俯仰、哈欠和头部转动的最新连续指标。还会了解如何将这些功能与 Core Image 等其他 API 结合使用,以在图像编辑 app 中提供从简单的虚拟背景到丰富的离线合成等各种内容。为了能充分了解本节内容,我们建议观看 WWDC20 中的“使用 Vision 检测身体和手部姿势”和 WWDC19 中的“理解 Vision 框架中的图像”。要了解有关人物分析的更多信息,请参阅 WWDC20...

-

36:34

36:34

包容性设计过程

探索如何提供包容性 app,从而为所有软件使用者带来令人惊喜的体验。我们将带领您了解建立和建设多元化团队的最佳实践,并探索包容性如何影响设计和开发过程的每个阶段。

-

32:44

32:44

可被发现的设计

探索如何创建交互式的、令人难忘的体验,引导新用户使用您的 app。我们将带您了解可被发现的设计实践,并了解您如何制作可探索、有趣的界面,帮助人们一目了然地领会到您 app 的可能性。我们还将展示如何应用这种方法来个性化您的内容并使您的 app 易于定制。

-

16:49

16:49

使用 Create ML 框架构建动态 iOS App

了解您的 app 如何使用 Create ML 框架在设备上彻底训练 Core ML 模型,带来自适应和自定义 app 体验,并始终保护数据隐私。我们将探索可以即时创建样式传输和图像分类等基于图像的任务、自定义声音分类等音频任务,或基于丰富的文本分类、表格数据分类和表格回归因子的任务的模型类型。我们将带您了解这些模型带来的各种精彩机会,让您的 app 更加个性化和动态化。请观看 WWDC21 的“使用 Create ML 对手势和动作分类”和“探索 SoundAnalysis 中内置的声音分类”,激发更多灵感。

-

26:49

26:49

使用 Create ML 将手势和动作分类

借助 Create ML,您的 app 能够更轻松地理解人类手势的表达。了解如何在 Vision 中构建对手势检测的支持,并使用 Create ML app 和框架训练自定义手势和手部动作分类器。了解收集数据、训练模型并将其与 Vision、Camera 和 ARKit 集成从而创造新奇有趣的 app 体验是何等简单。要了解有关 Create ML 和模型训练相关概念的更多信息,请查看 WWDC20 的“使用 Create ML 构建动作分类器”。另外不要错过“使用 Create ML 框架构建动态 iOS app”以了解如何在 app 中即时地以及在设备上训练模型。

-

19:12

19:12

用 Vision 提取文稿数据

了解 Vision 如何在您的 app 中提供专业图像识别和分析,以提取文档信息、识别各种语言的文本、以及识别条形码。我们将探索文本识别和二维码检测的最近更新,向您展示如何将所有这些工具与 Core ML 整合,帮助您的 app 通过图像和实时摄像头更好地感知世界。要了解更多关于 Vision 的信息,请观看 WWDC21 的“用 Vision 检测人员、人脸和姿势”和 WWDC20“探索计算机视觉 API”。要深入理解 Vision 的各种功能,请观看 WWDC21 的“用 Vision 检测人员、人脸和姿势”和 WWDC20 的“探索计算机视觉 API”。

-

14:22

14:22

使用 Accelerate 提高性能并纳入加密档案

Accelerate Framework 可帮助您进行大规模数学计算和图像计算,这些操作都经过高性能、低能耗优化。探索 Accelerate 及其“基础神经网络子程序”库的最新更新,包括附加层、激活函数和改进的优化器支持。查看 simd.h 的改进,包括更好的 C++ 模板支持。探索 Apple Encrypted Archive 支持,它是 Apple Archive 的扩展,其中结合了压缩与强大的加密和数字签名功能。同时,了解如何在不影响性能的情况下确保数据安全。

-

24:30

24:30

调整您的 Core ML 模型

利用 Core ML 将机器学习能力直接融入到您的 app。探索如何利用 CPU、GPU 和神经引擎提供最高性能,同时仍保留在设备上并保护隐私。探索能轻松处理 Swift 中多维数据的 MLShapedArray,并进一步了解 Core ML 中的 ML 包支持,包括 ML 程序支持。这种现代化的机器学习编程方法提供类型化执行和极大的灵活性。我们还将向您展示如何分析模型的性能,并使用 ML 程序调整模型中的各项操作执行。

-

29:12

29:12

使用 Metal Performance Shaders Graph 加快机器学习速度

Metal Performance Shaders Graph 是一种计算引擎,可帮助您为线性代数、机器学习、计算机视觉和图像处理构建、编译和执行定制的多维图形。了解 MPSGraph 如何通过 Apple 产品的 Metal 后台为热门的 TensorFlow 平台加速。了解如何向图形添加控制流、如何管理图形选集以获得最佳性能,以及如何借助 MPSGraph 的运作,仅使用几行代码就能为计算难度极高的 app 加快计算速度。

-

-

WWDC20 -

24:42

24:42

在 Core ML 中使用模型部署及安全性

探索如何在 app 二进制文件之外部署 Core ML 模型,从而在 app 中应用机器学习功能时为你提供更强的灵活性和控制能力。了解Core ML 模型部署如何让你将修改后的模型交付给你的 app 而无需更新。我们还将引导你逐步了解如何通过加密来保护自定义机器学习模型,并在 Xcode 中预览你的模型性能。 获取有关使用 Core ML 的更多信息,包括如何应用在 TensorFlow 和 PyTorch 等环境中训练过的模型,我们还建议你观看“使用 Core ML Converter 在设备上获取模型”。

-

24:21

24:21

使用 Vision 侦测身体与手部位姿

探索如何使用 Vision 框架帮助你的 app 侦测照片与视频中的身体与手部位姿。使用位姿侦测功能,你的 app 可以分析照片中人物的位姿、移动与手势,以此提供新的视频剪辑可能性。不仅如此,你还可以使用 Create ML 中自带的动作分类功能进行动作分类。此外,我们还将向你展示,如何通过手部位姿将手势识别融入你的 app,开放全新的互动形式。 要了解更多在动作分类功能中使用身体位姿的支持,请查看[“在 Create ML 中制作动作分类器”]与[“探索 Action & Vision app”]等节。另外,若要了解 Vision 中的其它绝妙功能,请查看[“探索计算机视觉...

-

26:06

26:06

用 Create ML 构建 Action Classifier

了解如何在 Create ML 中构建动作分类模型。使用自定义动作分类器,你的 app 可以从视频中或通过相机实时识别肢体运动。我们将向你展示如何使用示例轻松地训练 Core ML 模型,从而识别人类的动作,如跳跃、下蹲和舞蹈动作。 了解这是如何由计算机视觉框架内的身体位姿预测功能驱动的。你可以获取灵感,从而开发能够提供常规健身指导和对运动形式进行反馈等功能的app。要想充分利用此会议,建议先熟悉 “介绍Create ML app”。你也可以通过观看 “在 Creat ML 中构建健身运动分类模型”从而区分动作分类和基于传感器的健身记录分类。...

-

36:27

36:27

探索 Action & Vision app

如今,利用机器学习技术制作健身或运动教练 app 已经变得十分简单。为了证明这一点,我们自己也开发了一个 app。学习我们在设计 Action & Vision app 时,如何在 Create ML 中使用物体侦测与动作分类,以及 Vision 框架中全新的身体位姿预测、抛物线侦测与轮廓侦测功能。探索如何以设计制作——分析——反馈的步骤打造极具浸入感的游戏或训练 app。此外,我们还会提供一份完整的示例项目,供你边做边学。 为了在此节中达成最高的学习效率,建议你预先熟悉有关 Vision 框架与 Create ML 中动作分类器有关的内容。要了解更多,建议你查看[“使用 Create...

-

24:35

24:35

探索计算机视觉 API

学习如何将计算机视觉只能添加到你的 app,将 Core Image,Vision 与 Core ML 的力量结合起来。超越单纯的机器学习技术,对图片与视频产生更深层次的理解。探索 Core Image 与 Vision 的全新 API,以类似 Contour Detection 与 Optical Flow 的方式,将计算机视觉以全新阈值过滤器的方式加入你的 app。 要了解更多关于相关基础框架的内容,请查看“视觉框架:以 Core ML 为基础”与“Core Image:性能,原型开发与 Python”。若要进一步探索计算机视觉 API,请查看[“在 Vision...

-

11:48

11:48

在 Create ML 中构建图片 和视频风格转让模型

通过 Create ML 中的风格转换为你的照片和视频加入个性化的效果。了解如何在几分钟内训练模型,从而轻松将创意视觉功能应用至你的 app。了解训练过程以及用于控制结果的选项。我们将通过在 ARKit 中同时演示其中三个模型来探索这些模型的实时性能。 要想充分利用本节内容,建议先熟悉 Create ML。获取相关概述,请观看 “介绍 Create ML App”。

-

41:04

41:04

借助自然语言让 app 更聪明

了解如何利用自然语言框架更好地分析和理解文本。学习如何使用框架内置的单词和嵌入的句子从文本中提取含义,以及如何为满足特殊需要而创建自定义嵌入。 我们将向你展示如何使用示例训练自定义文本分类器,或如何运用标记器从文本中提取重要信息——上述都是自然语言中的迁移学习算法所驱动的。了解如何创建能够回答用户问题、识别文本相似性以及查找相关文档、图像等的 app。 为了充分利用本次分享,你应该对自然语言框架有一个基本的了解。你可参阅“自然语言框架概述”和“自然语言框架的发展”。你还可以通过“Create ML App 概述”来重温如何使用 Create ML。

-

31:16

31:16

使用 Core ML 转换器 为设备获取模型

借助 Core ML,你可以将优秀的机器学习模型应用至你的 app,并在设备上完整运行。 并且,在你使用 Core ML 转换工具时,几乎可以将 TensorFlow 或 PyTorch 中的所以训练过的模型都应用其中,并充分利用图形处理器,中央处理器和神经网络引擎。了解如何从其他 ML 平台转换现有模型,并了解如何创建可扩展模型功能的自定义操作。 如果你已经将模型转换为 Core ML,想进一步了解有关这些模型的部署策略,请观看 “通过 Core ML 使用模型部署和安全性”。

-

39:35

39:35

用 Metal Performance Shaders 图形 构建自定义 ML 模型

了解能够将 Metal 的计算能力提升至多维张量的 Metal Performance Shader(MPS)图形。MPS 图形基于对机器学习极为重要的高效数据并行图元资料库,并充分利用了 GPU 的强大功能。探索 MPS 如何协助实现复杂的动态神经网络训练架构,并通过对其优化来提升 GPU 速度。 若希望对此部分所提到的概念进行更为深入的理解,请观看 WWDC19 “机器学习方面的 Metal 应用”视频。

-

18:39

18:39

使用 Swift 在 Create ML 中进行控制训练

有了 Create ML 框架,开发模型和自动化工作流程将比以往更容易。 我们将向你展示如何在训练机器学习模型的同时探索它们并与之交互,从而帮助你快速开发更优良的模型。了解 Create ML 中的训练控制功能如何利用 checkpointing API 暂停、保存、恢复和扩展训练过程,从而自定义训练工作流程。 并了解如何使用 Combine API 程序化监视进度。 如果你还不熟悉 Create ML 并且有兴趣了解训练机器学习模型,建议观看“介绍Create ML APP”。

-

-

WWDC19 -

14:34

14:34

Create ML App 简介

要将 Core ML 的强大功能整合到您的 app 中,首先需要应对一个挑战。如何创建您的模型?新的 Create ML app 为模型创建提供了直观的工作流程。了解如何在这个简单易用的工具中快速训练、评估、测试和预览您的模型。从处理大量强大机器学习任务的诸多可用模板中选择一个入手。进一步了解用于持续改进和试验模型的众多功能。

-

40:38

40:38

Core ML 3 框架

Core ML 3 现在支持设备端机器学习之前从未能支持的高级模型类型。了解个性化模型如何为您的 app 带来绝佳的个性化机遇。更深入地了解将各种模型和改进链接到用于转换现有模型的 Core ML 工具的策略。

-

14:49

14:49

机器学习的新功能

Core ML 3 已得到极大扩展,能够在您的 app 中实现更加强大的设备端机器学习功能。了解如何通过新的 Create ML app 轻松地为众多任务构建 Core ML 模型。概括了解模型个性化,计算机视觉、自然语言、声音和语音方面的精彩更新,以及对先进模型类型的新增支持。

-

6:10

6:10

语音识别改进

语音识别程序现在可以在 iOS 或 macOS 设备本地使用,无需接入网络。了解如何在您的 app 中整合文字语音转换支持,同时保护隐私并消除基于服务器的处理的各种限制。语音识别 API 也得到了增强,可提供语速、停顿时长和语音质量等更加丰富的分析功能。

-

20:11

20:11

在 Create ML 中训练声音分类模型

了解如何快速、轻松地创建能够对音频文件和实时音频流中的声音进行分类的 Core ML 模型。Create ML app 不仅让您能够训练和评估这些模型,还允许您使用 Mac 上的麦克风实时测试模型性能。通过新的 Sound Analysis 框架,在您的 app 中使用这些设备端模型。

-

15:41

15:41

在 Create ML 中训练对象检测模型

自定的 Core ML 对象检测模型让您有机会为自己的 app 增添一些神奇的功能。了解 Xcode 中的 Create ML app 如何让训练和评估这些模型变得简单。看看您可以如何利用连续互通相机直接在 app 中测试模型性能。为 Core ML 构建和部署出色的对象检测模型变得从未如此简单。

-

12:05

12:05

在 Create ML 中训练文本分类器

现在,您可以通过 Create ML 创建基于先进技术的自然语言模型。了解如何通过 Create ML app 轻松地训练和测试这些模型。深入了解用于迁移学习、单词嵌入和文本目录的强大新增选项。

-

39:50

39:50

Understanding Images in Vision Framework

Learn all about the many advances in the Vision Framework including effortless image classification, image saliency, determining image similarity, and improvements in facial feature detection, and face capture quality scoring. This packed session will show you how easy it is to bring powerful...

-

10:31

10:31

在 Create ML 中训练推荐模型

Core ML 的推荐模型可以为使用您 app 的客户带来高度个性化的体验。这些模型能够在您日常使用的 app 中推荐音乐或影片。了解如何利用 Create ML app 根据各种数据来源轻松创建自定推荐模型。更深入地了解如何实现这种个性化,同时保护用户的隐私。查看这些推荐模型之一的实际应用案例。

-

15:01

15:01

在 Create ML 中构建活动分类模型

您的 iPhone 和 Apple Watch 搭载了许多功能强大的传感器,包括加速感应器和陀螺仪。可以使用来自这些传感器的数据训练活动分类器,从而为您的 app 增添一些神奇的功能,例如知道用户何时在跑步或挥动球棒。了解 Create ML app 如何让训练和评估这些 Core ML 模型之一变得简单。更深入地了解如何收集训练所需的原始数据。查看这些模型的实际应用。

-

39:19

39:19

自然语言框架改进

自然语言框架专为在所有 Apple 平台提供高性能的设备端自然语言处理 API 而设计。了解这个框架中新增的情感分析和文本目录支持。更深入地了解基于文本的模型的迁移学习,以及能够为您的 app 带来出色搜索体验的全新单词嵌入支持。

-

29:43

29:43

利用 Core ML 和 ARKit 创建出色的 App

开始学习之旅,了解如何结合利用 Core ML、ARKit 及其他 app 框架来创建教育游戏。探索利用机器学习为您的 app 带来神奇互动的机会。更深入地了解棘手计算机视觉问题的解决方法。在互动编程讲座中,观看这一切如何实现。

-

38:15

38:15

计算机视觉框架中的文本识别

借助计算机视觉框架中的文稿摄像机和文本识别功能,您可以从图像中提取文本数据。了解如何在您的 app 中利用这项内建的机器学习技术。更深入地了解快速处理和准确处理之间的区别,以及基于字符的识别和基于语言的识别之间的区别。

-

57:45

57:45

设计出色的 ML 体验

机器学习为我们带来了全新的体验,能够理解我们说的话,推荐我们可能喜爱的事物,以及让我们以各种各样的新方式表达自己。机器学习还能通过自动处理单调的任务并提高互动的准确性和速度,从而提升现有的体验。了解如何在您的 app 中整合 ML 体验,并获得关于轻松设计用户界面的实用方法。

-

41:25

41:25

Metal 助力机器学习

Metal Performance Shaders (MPS) 包括对于机器学习和充分发挥 GPU 的强劲性能必不可少的高度优调数据并行原语库。在 iOS 13 和 macOS Catalina 中,MPS 提升了性能,搭建更多神经网络,并且比以前更加简单易用。进一步了解 MPS 中的这些改进,并从实践角度了解如何实施样式转换等创新技术。

-